In den letzten Jahrzehnten zeigten sich beeindruckende Entwicklungsschritte. Insbesondere die aktuelle Wende zur Elektromobilität bringt neue vielversprechende Lösungen hervor. Fast alle Autohersteller starten Kooperationen mit innovativen Unternehmen aus der IT-Branche. Mit Waymo (Tochter des google Konzerns Alphabet) und Tesla haben sich zwei Lösungen zeitlich als auch funktional deutlich von den Wettbewerbern abgesetzt. Dabei stehen die beiden Unternehmen für zwei gegensätzliche Konzepte zum Thema "autonomes Fahren". Aber wie funktioniert so ein Autopilot? Und wie hebt sich die Lösung von Tesla ab?

Die Grundidee des autonomen Fahrens

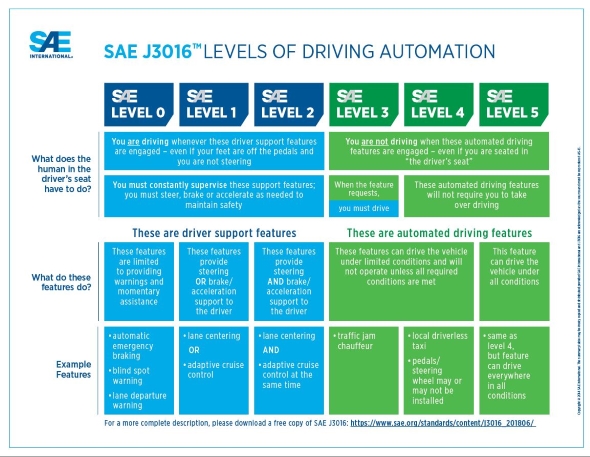

Die gemeinnützige Society of Automotive Engineers (SAE) beschreibt unter der Bezeichnung SAE J3016 eine Norm zum autonomen Fahren. Sie definiert 6 Stufen mit steigendem Automatisierungsgrad und gleichzeitigem Verantwortungsübergang vom Fahrer zum Fahrzeug. Daraus ergeben sich die Anforderungen für die Entwicklungs-Ingenieure und gleichzeitig die Herausforderungen für die Regulierer. Zu guter Letzt befassen sich sogar Ethik-Experten mit dem Thema, weil Algorithmen schlussendlich auch über Leben und Tod entscheiden können.

Quelle: SAE International

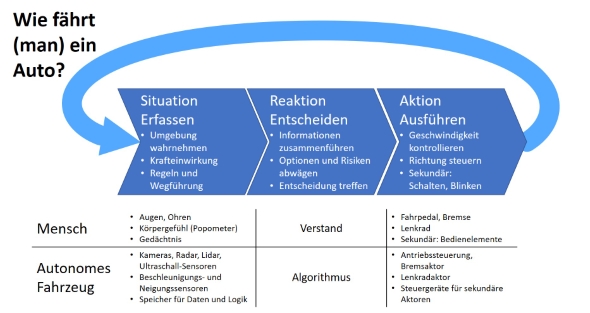

Die Kernfrage lautet: Wie funktioniert ein autonomes Fahrzeug? Die Antwort orientiert sich an der Fahrweise der Menschen. Was uns in der Fahrschule mühselig eingetrichtert wurde, entwickelt sich durch Fahrpraxis zur Routine: Der Fahrer erfasst die aktuelle Situation, er entscheidet über die nächsten Schritte, und er führt die damit verbundenen Aktionen aus. Diese drei Schritte werden dabei kontinuierlich im Kreis durchlaufen - genau so macht es auch das autonome System.

- Beim Erfassen der Situation ist es wichtig, das räumliche Umfeld inklusive der anderen Verkehrsteilnehmer zu erkennen. Während der Mensch sich dazu seiner sieben Sinne bedient, ist ein autonomes Fahrzeug auf Sensoren angewiesen. Dieser Schritt ist für das System die schwierigste Herausforderung und wird hier noch intensiv behandelt.

- Die Entscheidung über die Reaktion basiert auf den vorliegenden Informationen. Während der Mensch dabei hoffentlich seinen Verstand einsetzt, so nutzen heutige autonome Systeme relativ starre Algorithmen, die als klassische Prozeduren programmiert werden. Entgegen der landläufigen Meinung kommt bei aktuellen Systemen an dieser Stelle keine künstliche Intelligenz zum Einsatz.

- Die Ausführung von Aktionen zeigt sich primär durch Gas geben, Bremsen und Lenken. Sekundäre Aktionen unterstützen die Sicherheit oder Regeleinhaltung (Blinken, Licht, Scheibenwischer, usw.). Damit ein autonomes System auf diese Aktionen zugreifen kann, werden die Bedienelemente über Aktoren angesprochen. Das ist entweder ein Kraftantrieb für eine mechanische Bedienung (Elektrische Bremse, Servo-Lenkung) oder eine Elektronik / Software für eine digitale Bedienung (Blinker, Licht).

Die Digitalisierung im Fahrzeugbau bereitet den Weg für die Konstruktion autonomer Fahrzeuge. Sensoren, Aktoren und Steuergeräte werden über ein Bussystem vernetzt. Sämtliche mechanischen Komponenten sind mit entsprechenden Stellantrieben und Servo-Motoren versehen. Die Logik zur Bedienung von Fahrfunktionen ist über Software realisiert. Der Wandel zur Elektromobilität ist damit eng verbunden, weil dabei ebenfalls eine Verlagerung kritischer Funktionen hin zu Elektronik und Software stattfindet und weil elektrische Energie ausreichend vorhanden ist. Dies ist aber keine notwendige Voraussetzung für autonomes Fahren. Das funktioniert auch mit entsprechend ausgestatteten Verbrenner-Fahrzeugen.

Wie nimmt das autonome System sein Umfeld wahr?

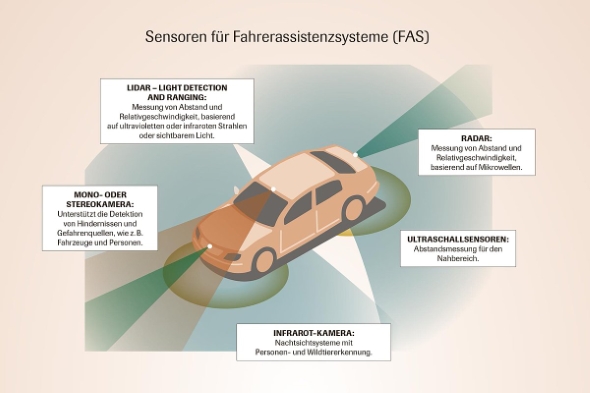

Für einen Computer ist es komplex, die unmittelbare Umgebung zu erfassen und eine Prognose für den Verlauf zu erstellen. Dabei geht es vor allem um die räumliche Wahrnehmung des Umfeldes. Das System muss den befahrbaren Raum erkennen und die zulässigen Fahrwege ermitteln, gleichzeitig sämtliche Verkehrsteilnehmer identifizieren sowie deren Bewegungsrichtung und Geschwindigkeit einschätzen. Für diesen Zweck werden unterschiedliche Sensoren eingesetzt:

- Kameras ermöglichen die visuelle Erfassung der Umgebung und ähneln dem menschlichen Sehen. Je nach Auflösung kann man detailreiche Bilder erzeugen. Sie haben Schwächen bei schlechten Sichtverhältnissen wie Dunkelheit, Regen oder Blendung durch die Sonne. Filter ermöglichen spezielle Funktionen wie Nachtsichtfähigkeit oder Wärmeerkennung (Infrarot).

- Lidar-Sensoren (Light Detection And Ranging) arbeiten wie rotierende Leuchttürme und bestrahlen die Umgebung mit unsichtbaren Laserimpulsen. Aus den Laufzeiten der Reflexionen wird ein dreidimensionales Punkte-Modell der Umgebung errechnet. Der Lidar erzeugt kein visuelles Bild. Er arbeitet auch bei Dunkelheit, ist aber anfällig für Regen, Schnee und Nebel, weil die Strahlen blockiert werden.

- Radar-Sensoren können den Abstand entfernter Objekte ermitteln. Sie liefern keine detailreichen Informationen. Dafür können sie aber wie ein Echolot durch den Nebel stechen oder z.B. mittels bodennaher Radarwellen frühzeitig das Bremsen des Fahrzeugs vor dem Vordermann wahrnehmen.

- Ultraschall-Sensoren kennt man von piependen Einparkhilfen. Sie erfassen Objekte in unmittelbarer Nähe (bis ca. 2 Meter) und schützen vor verdeckten Findlingen, Mauervorsprüngen oder Fahrbahnbegrenzungen. Sie erlauben eine gute Einschätzung des Abstands zu einem Objekt, erkennen aber nicht, um was es sich handelt. Die Sensoren sind oft als Gruppe rund ums Fahrzeug angeordnet und helfen beim Rangieren und beim Durchfahren enger Passagen.

Quelle: VDI

Bei modernen Fahrzeugen werden die unterschiedlichen Sensor-Typen funktional überlappend eingesetzt. Man bezeichnet das als diversitäres Design: Der Ausfall einer Sensor-Art wird von einem Sensor anderen Typs aufgefangen. Zum Beispiel kann eine vom Regen verdeckte Kamera durch ein Radar / Lidar ergänzt werden. Das ist nicht zu verwechseln mit der (vom Gesetzgeber teilweise vorgegebenen) Redundanz von Systemen. Sie beschreibt die doppelte Ausführung von kritischen Teilsystemen wie Steuergeräte, die sich gegenseitig kontinuierlich überwachen und bei Bedarf füreinander einspringen (Fail-Over).

Die Hersteller von autonomen Fahrsystemen verfolgen inzwischen ähnliche Konzepte. Sie kombinieren Sensoren, sie vernetzen die Fahrzeuge mit zentralen Servern und untereinander zum Datenaustausch und sie bleiben bei klassischen Methoden des Fahrzeugbaus. Lediglich Elon Musk als CEO und Visionär der Tesla Motor Company hat sich bereits vor Jahren festgelegt, andere Wege zu gehen. Ursprünglich von den Experten belächelt, verzeichnet Tesla inzwischen beachtenswerte Erfolge. Bleibt die Frage: Was macht Tesla anders und warum kann der Plan funktionieren?

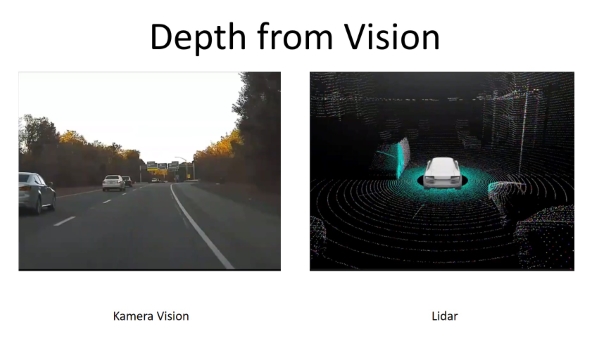

Unterschied 1: Tesla's Kamera-basiertes Full Self Driving

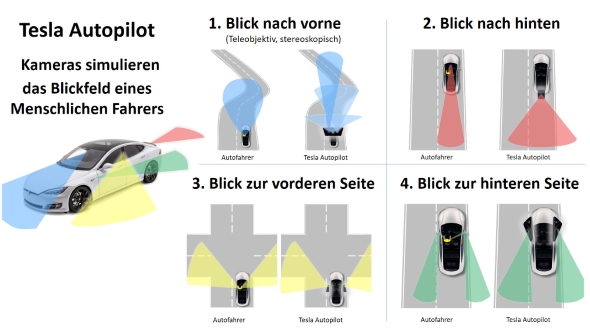

Elon Musk spricht sich gegen den Einsatz von Lidar-Sensoren aus. Sie sind konstruktionsbedingt aufwändig und teuer, was sich negativ auf die Kosten und die Marge auswirkt. Stattdessen sollen Kameras, die über einen leistungsstarken Computer vernetzt werden, das Problem des räumlichen Wahrnehmens besser und günstiger lösen. Ein Mensch kann beim Autofahren die Umgebung schließlich auch rein visuell mit den Augen erfassen. Das Prinzip der vier Hauptblickrichtungen will Musk auf das autonome Fahrzeug übertragen:

- Der Blick nach vorne (durch die Windschutzscheibe) erfasst die befahrbare Fläche und Fahrwege, Hindernisse und entgegenkommende Verkehrsteilnehmer.

- Der Blick nach hinten (über die Schulter oder den Innenspiegel) identifiziert von hinten kommende Verkehrsteilnehmer und ermöglicht ein sicheres Rückwärtsfahren.

- Der Blick nach links und rechts vorne (durch die Seitenscheiben) prüft Querstraßen und Einmündungen und ermöglicht das Beachten von Vorfahrtsregeln.

- Der Blick nach links und rechts hinten (über die Schulter oder die Außenspiegel) zeigt sich seitlich nähernde Verkehrsteilnehmer beim Spurwechsel oder beim Abbiegevorgang.

Die acht Kameras in einem Tesla decken genau diese vier Blickrichtungen ab. Es sind drei Kameras nach vorne (je eine Weitwinkel, Normal, Teleobjektiv), eine Kamera nach hinten, jeweils eine Kamera in den B-Säulen nach vorne zur Seite und jeweils eine Kamera in den vorderen Kotflügeln nach hinten zur Seite.

Während der Mensch immer nur in eine Richtung blicken kann, laufen die Kameras im Tesla gleichzeitig mit einer hohen Bildwiederholfrequenz. Der von Tesla selbst entwickelte FSD-Computer (Full Self Driving, Autopilot Version 3) ist in der Lage, bis zu 2300 Bilder pro Sekunde zu verarbeiten. Für die Auswertung der Bilder stehen zwei Chips mit 36 Billionen Rechenoperationen pro Sekunde zur Verfügung. Damit kann Tesla auch ohne Lidar-Sensor eine räumliche Sicht auf die Umgebung erzeugen:

- Der Abstand der zwei äußeren vorderen Kameras ist gleich dem Augenabstand eines erwachsenen Menschen. Damit kann man stereoskopische Bilder in Fahrtrichtung erzeugen, so wie auch ein Mensch räumlich sehen kann.

- Der leistungsfähige Full-Self-Driving-Computer (Autopilot 3) erzeugt seit neuestem aus den 8 Einzelbildern der Kameras eine 360-Grad-Rundum-Sicht. Taucht ein anderes Fahrzeug oder ein Hindernis im Blickfeld mehrerer Kameras auf, wird es durch die neue Sicht als ein eindeutiges Objekt erkannt und kann genau verortet werden.

- Darauf aufbauend arbeitet Tesla mit Verfahren wie SLAM (Simultaneous Localization and Mapping). Dabei analysiert der Computer kontinuierlich das 360-Grad-Bild, während sich das Fahrzeug oder die Objekte bewegen. Durch die Analyse der relativen Veränderungen errechnet das System eine spontane 3D-Karte der unmittelbaren Umgebung. Die Software erzeugt so eine Punkte-Wolke, die der Funktion eines Lidars ähnelt, auch wenn sie weniger genau ist.

Quelle: Tesla

Gerade diese Technologien aus dem Bereich der künstlichen Intelligenz nutzt Tesla, um sich weiter von anderen Herstellern zu differenzieren.

Unterschied 2: Einsatz von künstlicher Intelligenz beim Autonomen Fahren

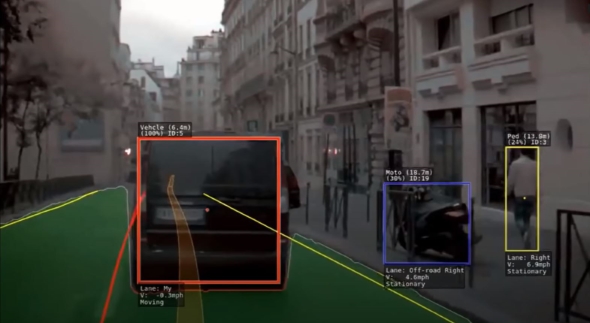

Wie kann ein Computer erkennen, was auf dem Bild zu sehen ist? Wo ein Mensch die Straße, den Gegenverkehr und die Baustellenbegrenzung sieht, steht der Computer zunächst vor einer großen Menge von Farbpixeln. Hier kommt die Computer Vision zum Einsatz, ein Teilgebiet aus der Forschung zum Thema künstliche Intelligenz. Durch maschinelles Lernen wird dem Computer beigebracht, die Inhalte aus Bildern zu verstehen. Autonome Fahrzeuge erkennen so die Fahrbahn und relevante Objekte im Bild, wie andere Autos, Motorräder, Fahrräder, Fußgänger, Baustellen und Mülltonnen. Tesla verprobt zur Zeit seinen neuen 4D-Autopiloten als Beta Software an Testfahrzeugen. Dieser ermittelt die Geschwindigkeit und Bewegungsrichtung von Objekten durch die Lageveränderung auf den Bildern über die Zeit. Auf Basis dieser Daten wird der nächste Schritt prognostiziert und die Reaktion frühzeitig eingeleitet. Das folgende Bild zeigt, wie der Tesla das Objekt im richtigen Bildausschnitt markiert und die dazugehörigen Daten zuordnet.

Quelle: Tesla

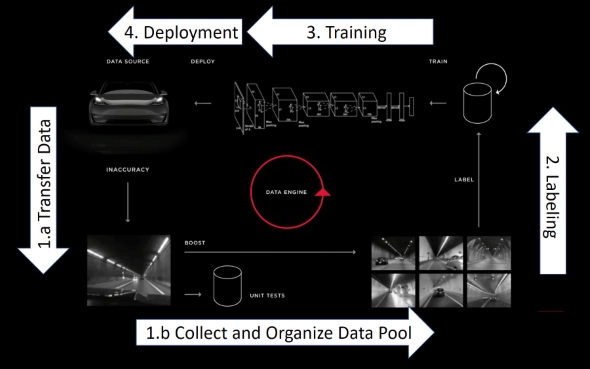

Das Gehirn des Menschen dient als Vorbild für das künstliche Neuronale Netz, dem Herzstück des Erkennungsverfahrens. Indem man dem Computer wiederholt unterschiedliche Bilder eines bestimmten Objekts vorlegt, lernt das neuronale Netz mit der Zeit, diesen Objekttyp auch in bisher unbekannten Bildern zu erkennen. Richtige Erkennungen führen zu einer Verstärkung des Prozesses und Fehler werden zurückgespielt. Dadurch verbessert sich die Erkennungsrate kontinuierlich mit jedem Bild. Diesen Vorgang nennt man Trainieren. Das Markieren der Objekte in den Trainingsdaten wird als Labeling bezeichnet. (Details im Video zum Tesla Autonomy Day).

Fast alle Hersteller setzen neuronale Netze für die Bildanalyse ein, aber Tesla hat den Prozess signifikant perfektioniert:

- Die Erkennungsrate steigt mit dem Umfang an Trainingsdaten. Tesla gewinnt die erforderlichen Bilder aus den bereits vorhandenen hunderttausenden Fahrzeugen weltweit (Fleet Learning). Gezielte Situationen werden beim Fahren aufgezeichnet und über Nacht als Paket an Tesla übertragen (siehe dazu auch die Datenschutz-Einstellungen im Auto). Insbesondere Momente, in denen der Fahrer in das Autopilot-System eingreift, sind als Informationsquelle für Fehler interessant. Im sogenannten "Shadow Mode" vergleicht das Fahrzeug das Verhalten des Fahrers im manuellen Fahrbetrieb mit der errechneten Reaktion des Autopiloten und ergänzt damit die Trainingsdaten. So hat jeder Tesla z.B. zum Erkennen von Ampeln beigetragen, lange bevor die Funktion für die Fahrer sichtbar war. Während Wettbewerber mangels Alternativen auf künstlich erzeugte Trainingsdaten setzen müssen (Simulation), hat Tesla Milliarden von realistischen Datensätzen. Das ermöglich eine Trefferquote, die kein anderer Hersteller mit seinem neuronalen Netz erzielt.

- Tesla investiert immense Aufwände in das Labeling von Testdaten. Ein großes Team von Mitarbeitern markiert in den gewonnenen Bildern die relevanten Objekte für den nächsten Trainingslauf bzw. korrigiert fehlerhafte Erkennungen. Aktuell arbeitet Tesla an einem automatischen Labeling-System, das diesen Prozessschritt noch weiter revolutioniert. Das ermöglicht das Einbeziehen von noch mehr Trainingsdaten in der gleichen Zeit.

- Für das Training des neuronales Netzes nutzt Tesla einen eigenen Super-Computer. Aktuell benötigt ein Trainingsdurchlauf 70.000 GPU-Stunden (ein Rechenkern, eine Stunde lang), bei dem 48 Netzwerkschichten (die Grundlage für neuronale Netze) durchlaufen werden. (Quelle: Tesla).

- Tesla setzt in der Software-Entwicklung auf eine agiles Arbeitsmodell mit einen Update-Zyklus der Fahrzeug-Software von vier Wochen. Die Verbesserung der Erkennungsrate wird damit innerhalb kürzester Zeit über die Software-Updates an die vorhandenen Fahrzeuge weiter getragen und bereits ausgelieferte Fahrzeuge bleiben auf dem gleichen Stand. Das ist in der Autoindustrie bisher ein Novum.

Quelle: Tesla

Unterschied 3: Wie erreicht man echte Autonomie?

Ein Autofahrer berücksichtigt, ob er über unbekannte Straße befährt oder die Strecke bereits kennt. Er fährt auf Sichtweite oder er weiß, was hinter der nächsten Kurve kommt. Auch die Konzepte der Hersteller autonomer Fahrzeuge unterstützen beide Varianten: Sie können den Streckenverlauf mittels ihrer Sensoren spontan erfassen oder sie nutzen vorhandene Kartendaten, um das Fahren vorhersehbarer und sicherer zu machen. Wenn man genau hinsieht, erkennt man bei den heutigen Lösungen relevante Unterschiede.

- Die Alphabet-Tochter Waymo (google) setzt bei ihrem System auf hochauflösende Karten. Das Fahrzeug kennt die Straßenführung und Kreuzungen und weiß, wie viele Spuren die Straße hat und wo welche Verkehrsschilder stehen. Diese Daten bestimmen primär die Wegeführung, während die Kamera-Bilder und der Lidar die Karteninformationen ergänzen und helfen, spontane Hindernisse zu erkennen. Die Logik ist dadurch weniger komplex und das Fahrzeug fährt durch die Kartenorientierung quasi wie auf unsichtbaren Schienen. Voraussetzung ist, dass das detaillierte Kartenmaterial für das betroffene Gebiet vorliegt, die darin enthaltenen Daten aktuell sind und eine lückenlose Verbindung zu den Karten-Servern verfügbar ist.

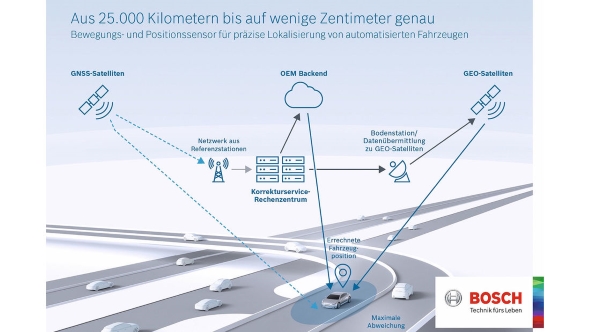

- Der Autozulieferer Bosch entwickelt seit 2018 ein System für autonome Fahrzeuge, welches die Lokalisierung des Fahrzeugs mit Hilfe von Globalen Navigations-Satelliten-Systemen (GNSS) vornimmt. Weil diese Verfahren für eine präzise Ortsbestimmung zu ungenau sind, greift Bosch zusätzlich auf Korrekturdaten zurück, die von Referenzstationen auf der Erde stammen (Quelle: Auto-Motor-Sport).

- Die Mobilfunk-Anbieter Deutsche Telekom und Vodafone halten die Nutzung des neuesten Mobilfunkstandards 5G für die Einführung von autonomen Automobilen für unerlässlich. Die Fahrzeuge sollen über eine latenzfreie Kommunikationsverbindung permanent mit anderen Fahrzeugen in Verbindung stehen sowie mit intelligenten Sensoren und Aktoren in der Straße, in Ampeln oder anderen verkehrssteuernden Systemen.

Quelle: Bosch

Die genannten Beispiele versprechen einen hohen Grad an Sicherheit. Aber sie funktionieren nur auf kartografierten Straßen, in Verbindung mit einer globalen digitalen Infrastruktur oder mit einer permanenten Echtzeit-fähigen Kommunikationsverbindung. Man erwartet, dass ein Großteil der Fahrzeuge an der kollektiven Vernetzung teilnimmt - über alle Hersteller und Ländergrenzen hinweg. Das funktioniert in der Theorie oder in einer fernen Zukunft, aber Elon Musk betrachtet es nicht als realistische Option in den nächsten Jahren. Tesla möchte seine Fahrzeuge aber bereits kurzfristig autonom fahren lassen. Dementsprechend muss bereits diese Generation von autonomen Fahrzeugen in sich geschlossen funktionieren, so wie auch ein Mensch ohne fremde Hilfe ein Auto fahren kann.

Auch Tesla nutzt Karteninformationen z.B. für die Erkennung von Streckenbegrenzungen oder den Standorten von Ampeln. Auch eine kontinuierliche Internet-Verbindung unterstützt bei sekundären Funktionen wie das Laden von Verkehrsdaten oder bei der Berechnung von intelligenten Navigationsrouten. Aber das Fahrzeug wird auch ohne diese Informationen autonom fahren, egal wo auf der Welt man es auf eine Straße setzt und unabhängig davon, ob die Fahrzeuge im Umfeld ebenfalls autonom fahren oder von einem Menschen gesteuert werden.

Fazit

Teslas Konzepte sind keine Raketenwissenschaft, die Technologien stehen Allen zur Verfügung. Dennoch tun sich die traditionellen Fahrzeughersteller schwer, diesen Vorsprung aufzuholen und ähnlich pragmatisch zu sein. Die Versuche scheitern nicht an der Technologie, sondern an der Bereitschaft zum radikalen Umdenken und an der Unternehmenskultur. Die Veränderungsbereitschaft und die kontinuierliche Verbesserung sollten an vorderster Stelle stehen.

Das bisherige Geschäftsmodell, kontinuierlich neue Autos zu verkaufen, wird überholt von der Idee, Mobilität als Dienstleistung anzubieten. Wenn die Fahrzeuge langlebig und kostengünstig herstellbar sind und als Teil einer autonomen Flotte eingesetzt werden, dann wird die Mobilität so preisgünstig, dass der Kauf eines eigenen Autos keinen Sinn mehr macht.

Noch ein Wort zum Schluss: Technische Sensoren können die Fähigkeiten einzelner menschlicher Sinnesorgane übertreffen. Aber die Leistungsfähigkeit unseres Gehirns ist nach wie vor ein Wunder der Natur. Keine verfügbare Technologie ist vergleichbar mit der menschlichen "Wahrnehmungs- und Interpretationsmaschine" in unserem Kopf. Der Weg sich dem anzunähern geht nicht über die Optimierung der Sensoren, sondern über die Software. Tesla hat das erkannt und sein Unternehmen darauf ausgerichtet. Die Aufholjagt hat längst begonnen.

Quelle: Tesla

Das T&Emagazin

Der Artikel ist erschienen in der Ausgabe 9 (Januar 2021) des T&Emagazins.

Das T&Emagazin entsteht durch Beiträge der Community und behandelt Themen rund um E-Mobilität und Energiewende.

Das T&Emagazin ist an rund 350 Auslageorten im deutschsprachigen Raum kostenlos zu finden. Interessierte, die das Heft bequem zuhause im Briefkasten haben wollen, können es jedoch auch gegen Übernahme der Versand- und Portokosten über den T&Eshop anfordern. Wer 5, 10 oder auch 20 Hefte haben möchte, kann bequem entsprechende Pakete ordern. Zudem besteht die Möglichkeit, das T&Emagazin in Wunschmenge dauerhaft zu abonnieren.

Zum Thema Autopilot gibt es auf dem Kanal "einfach elektrisch" ein gemeinsames Video mit Oliver Bornemann und mir,